Si tienes tu propio negocio o un sitio web para generar dinero, SEO es lo que estabas buscando. Pero, si no te dedicas al marketing, si eres un atleta de la NCAA, te has especializado en otra cosa. Son muchas las cosas que forman parte de un buen SEO.

Por ejemplo, tenemos…

- Palabras clave

- Backlinks (enlaces de retroceso)

- SEO técnico

- Marketing de contenidos

- Experiencia de usuario

Sí, tienes razón, suena como mucho curro. Pero, ¿no habrá alguna manera de hacerlo todo más fácil?

Bueno, si tienes un SEO Crawler, sí.

¿Qué es un SEO Crawler?

En el contexto del SEO, “crawler“ y “crawling” se refieren a cosas diferentes, dependiendo del contexto. Si hablamos de motores de búsqueda, como Google, los “crawlers” se refieren a los programas que navegan por la web, siguiendo enlaces de una página a otra. “Crawling” se refiere al rastreo y la lectura que realizan los bots de cada motor de búsqueda al llegar a una página.

Después de realizar el “crawling“ de una página, en el paso llamado “indexación”, los motores de búsqueda guardan una copia y algo de información sobre la página en sus servidores. El objetivo del SEO técnico es que tus páginas sean más accesibles y más fáciles de indexar para los crawlers de los motores de búsqueda.

Si embargo, también existen los crawlers de otros motores de búsqueda, aparte de Google (o Bing, o Baidu, o Yandex...). Los SEO crawlers funcionan de la misma manera que los crawlers de los motores de búsqueda. Siguen los enlaces del sitio web, recolectando la información sobre las páginas que encuentran. La diferencia es que estos crawlers no indexan las páginas.

En vez de esto, generan datos que los vendedores podrán usar para mejorar su SEO técnico.

Básicamente, los crawlers y las herramientas de SEO los usan los vendedores para ver un sitio web a través de los ojos de un Googlebot.

¿Qué es lo que me puede decir un Site crawling?

Bueno, como mencionamos arriba, si usas un SEO crawler para tu sitio web, es como si te hubieras puesto un par de gafas de Googlevision para ver tu sitio web. Un buen SEO crawler es una herramienta muy poderosa que te mostrará todos los problemas que puedas tener con el SEO técnico y el contenido de tu página web.

Problemas como...

Contenido duplicado

Uno de los miedos más grandes del SEO, el contenido duplicado, es un tema aparte. Lo que pasa es que hay muchísimas maneras de acabar teniendo contenido duplicado en tu sitio web sin que lo sepas (algo que habrás pillado hasta ahora si has estado leyendo este blog de vez en cuando).

Puedes acabar teniendo contenido duplicado debido a:

- Listas paginadas

- Un mismo producto disponible en diferentes colores o tamaños

- Los problemas con plantillas pueden causar títulos o descripciones duplicados

- Diferentes páginas en una misma lengua dirigidas a diferentes regiones geográficas

- Errores de CMS (sistema de gestión de contenidos)

Estos problemas son bastante fáciles de encontrar y resolver individualmente. Solo agrega los tags rel=“prev”/“next” a tu lista paginada para solucionar ese problema o agrega un redireccionamiento 301 a tu sitio cuando muevas una página.

¿Pero qué pasa con los sitios que tienen muchas páginas, mucha paginación, muchísimos productos?

En ese caso, necesitas un crawler para resolver estos problemas.

Cuando descubras un contenido duplicado por accidente, lo puedes resolver agregando un tag canonical y/o un redireccionamiento a esa página.

Un buen SEO crawler también lo revisa en vez de ti. Los tags canonicales que no coinciden con los sitemaps de los URL o te llevan a páginas 404 no te sirven de nada, así que, si la herramienta que usas no encuentra estos tags, no es de gran ayuda.

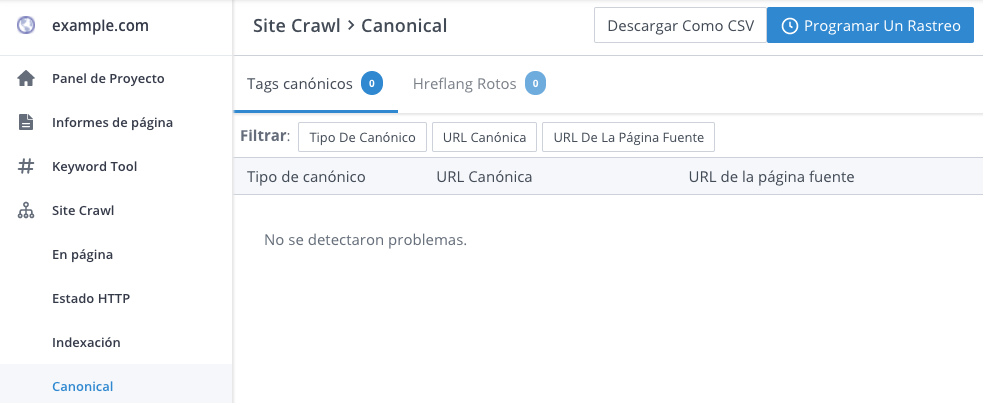

Aquí te mostramos el Site Crawl de WooRank cuando detecta que un sitio web no tiene ningún URL canonical roto:

Asuntos de indexación

La razón por la que los crawlers existen en primer lugar es para averiguar el grado de indexación de tu sitio web. Por eso, un buen SEO crawler encontrará los errores de indexabilidad de tus páginas.

Ojo: estos se refieren tanto a las páginas que quieres indexar, como a las que no.

Usar robots.txt y el tag de meta robot es una buenísima manera para que las páginas que no quieras incluir se omitan en los resultados de búsqueda de Google. Pero, si no los usas bien, puede ocurrir que la gente acabe viendo páginas que no quieres que vean, mientras que otras se omitan completamente.

Los resultados de tu SEO crawl te deben dar una lista de páginas que están desactivadas a través de robots.txt y los tags de noindex. Así, puedes estar seguro/segura de que todas las páginas que quieras están en el lugar en el que quieras que estén.

Redireccionamientos que no funcionan

Los redireccionamientos no son lo ideal, ya que hacen que tu página sea más lenta, pero son necesarios si quieres mover una página o un sitio web entero. Lo bueno es que si usas los redireccionamientos 301 y 301, podrás pasar todo el contenido de tanto los enlaces internos como los externos.

Si usas los 301 y los 302, puedes crear problemas en tu sitio web. De hecho, varios problemas:

- Redireccionamientos rotos: bastante fáciles de entender, son los que mandan a los usuarios a páginas rotas o de error.

- Cadenas de redireccionamientos: un redireccionamiento te lleva a un URL que también redirecciona, creando una cadena. Por cierto, las cadenas no solo se limitan a dos eslabones. Las cadenas son igual de malas para la experiencia de usuario como para el SEO, el tiempo de carga es más lento y, para ser honesto, hacen que no te veas muy digno de fiar.

- Círculos de redireccionamientos: se forman cuando dos páginas se redireccionan entre sí, por lo que los usuarios acaban rebotando entre páginas que nunca se terminan de cargar. Página diseñada por M.C. Escher.

Sin tu SEO crawler tendrías que encontrar todos estos redireccionamientos tú solo y probarlos. De nuevo, esta no es una opción factible para la gran mayoría de los dueños de sitios web. Sin embargo, con una herramienta como Site Crawl puedes revisar todos tus enlaces en cuestión de horas.

Páginas de baja seguridad

La importancia de la seguridad es clave para tu sitio web, sobre todo si manejas algún tipo de información personal o financiera. Esto es importante para tus usuarios y es importante para Google. El problema ocurre cuando no terminas de migrar completamente toda la información de tus URL HTTP a los HTTPS.

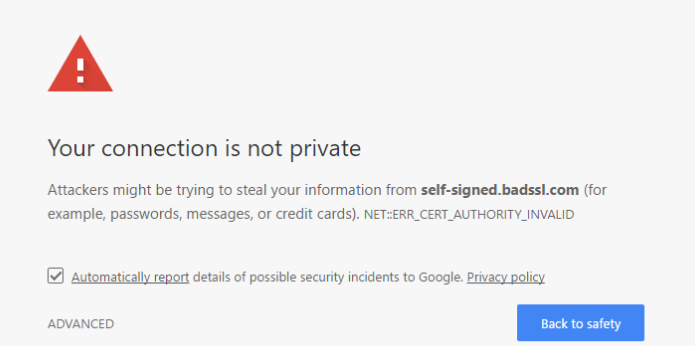

Cuando esto ocurre, no solo tus páginas se vuelven menos seguras, sino que la gente empieza a ver esas horribles páginas de alerta cada vez que quieren entrar en tu página. Estas páginas no solo no se indexarán, sino que también podrían hacer que baje el ranking de todo tu dominio.

Además, si visitaras un sitio web y vieras la alerta de seguridad, ¿regresarías a ese sitio?

¡Ha llegado la hora de las palabras clave!

Perfecto, ya has creado y revisado los aspectos técnicos de tu sitio web. ¿Listo?

Todavía no.

Ahora tienes que echar un vistazo a tu contenido on-page para asegurarte de que estés sacando el máximo provecho de tu manera de usar las palabras clave.